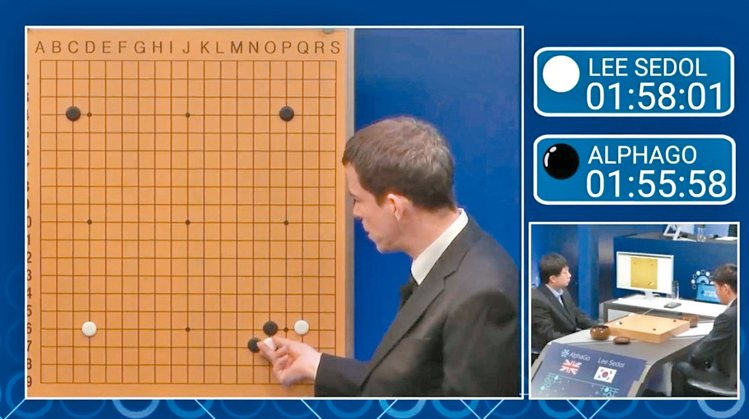

谷歌人工智慧系統AlphaGo與南韓圍棋世界棋王李世乭九段對弈三場皆捷後,雙方13日在首爾繼續第四場對決。AlphaGo與李世乭總共將對弈五場。無論前三場勝負如何,雙方將賽完五場。

這種結果促使許多人開始認真思考「人與機器」間的關係可能如何演變的課題。畢竟,如果AlphaGo能夠在「感覺」是主要關鍵的複雜比賽中獲勝,它有朝一日可能取代一般人的工作?

科學家說,短期內還不至於。機器人近年來進展快速,卻因為仍然太過專注而無法取代人類。艾倫人工智慧研究所執行長艾奇歐尼表示,指導電腦閱讀並回答相關問題的研究仍未完成。例如,他指示電腦閱讀第八級的科學教科書內容後,它們只能回答約60%問題。他說:「理解一個句子可能比下棋複雜許多。」他說,電腦仍待證明,它們「可以解決更模糊不清的事」。

圍棋規則簡單,但落子變化無窮盡,谷歌的人工智慧團隊當初看中這種複雜性而研發AlphaGo。人工智慧專家李維說,這意味,AlphaGo接連擊敗圍棋高手的意義尤甚於IBM「深藍」電腦系統1997年擊敗世界西洋棋冠軍卡斯帕洛夫。

Atari遊戲公司創辦人布許奈爾說:「圍棋是我此生最重要遊戲。它是唯一可以平衡大腦左右兩側的遊戲。電腦科技在這領域勝出的結果非常重要。」

但這並不意味機器即將取代人類。華盛頓大學電腦科學教授說:「圍棋畢竟只是規則非常簡單的人為問題。設計居家機器人截然不同;它必須具備常識與肢體靈活等特性。人工智慧仍然欠缺這些。」

經濟學人雜誌報導,與南韓棋士李世乭對戰的AlphaGo軟體,是採用深層學習的技術,藉由複雜的統計方法,讓電腦從龐大且雜亂的資料中淬取出通用的法則,對於如何下棋發展出本身的直覺反應。

深層學習需要大量處理能力、與可供學習的資料等兩項要件。DeepMind訓練電腦時,從網路上挑選出3,000萬種業餘及職業棋士對奕的棋譜,與AlphaGo對戰。這些資料被輸入兩種深層學習演算模式。一為政策網路,訓練電腦模擬真人的下法,讓電腦學會找出各種特點、原則及法則,產生並建議多種似乎可靠的下法。

第二套演算模式為「價值網路」,根據政策網路的建議,評估每種下法的作用。價值網路只評估後幾手的可能情況,找出最可能的勝著。這兩套演算模式結合了真人棋手多年來累積的經驗。

留言列表

留言列表